能用的磁力链接搜索网站

*** 次数:1999998 已用完,请联系开发者***

海外资本投资热情持续升高——中国市场“磁力十足”网站报道,多年来,跨国企业纷纷进入中国,中国日益壮大的消费者群体和丰厚的利润前景对跨国企业十分具有吸引力。中国美国商会最近公布了一份针对300多家会员企业的调查报告。报告称,会员企业对中国接下来两年商业前景的预期表现乐观,中国作为投资目的地“磁力十足”。苹果公...

不敢对比Qwen2.5,Mistral最强小模型陷争议,欧洲OpenAI不Open了Mistral AI以先丢出神秘磁力链接、开放模型权重,几天后再发技术报告的独特作风,成为开源社区新宠。但如今,这家“欧洲的OpenAI”也渐渐不Open了。在2024年初,Mistral AI宣布与微软合作,同期推出的Mistral Large大模型不再开放权重,并悄悄撤回了官方网站上有关开源社区义务的内...

⊙▂⊙

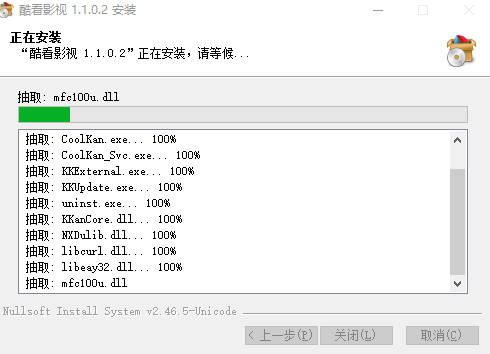

想让影院刮削更准确,一定要注意文件命名格式下载资源通常搜索影视资源,我们会直接搜“影视名+年份+磁力下载”会更准确一些,我习惯用迅雷下载直接复制资源的磁力链接,点击确认稍等片刻即可。影视文件命名-批量重命名往往我们下载后的文件名称中会包含一些奇怪的内容或多余信息,但总是这些不起眼的细节会导致影视剧集...

开源大模型超越GPT-3.5!爆火MoE实测结果出炉可以用上的磁力链接或通过Hugging Face下载之后在本地部署。在上,已经有不少网友在自己的设备上跑起了Mixtral,还给出了性能数据。在128GB内存的苹果M3 Max设备上,使用16位浮点精度运行Mixtral时消耗了87GB显存,每秒可以跑13个token。同时也有网友在M2 Ultra上通过llama.c...

首个开源MoE大模型发布!GPT-4同款架构,来自欧洲的OpenAI只靠一个磁力链接,就产生如此轰动效果。具体参数还得是网速快的人下载完之后,从配置文件里截图发出来的:7B参数x8个专家,对每个token选择前两个最相关的专家来处理。以至于OpenAI创始成员Karpathy都吐槽,是不是少了点什么?怎么缺了一个那种排练很多次的专业范视频,大谈特谈...

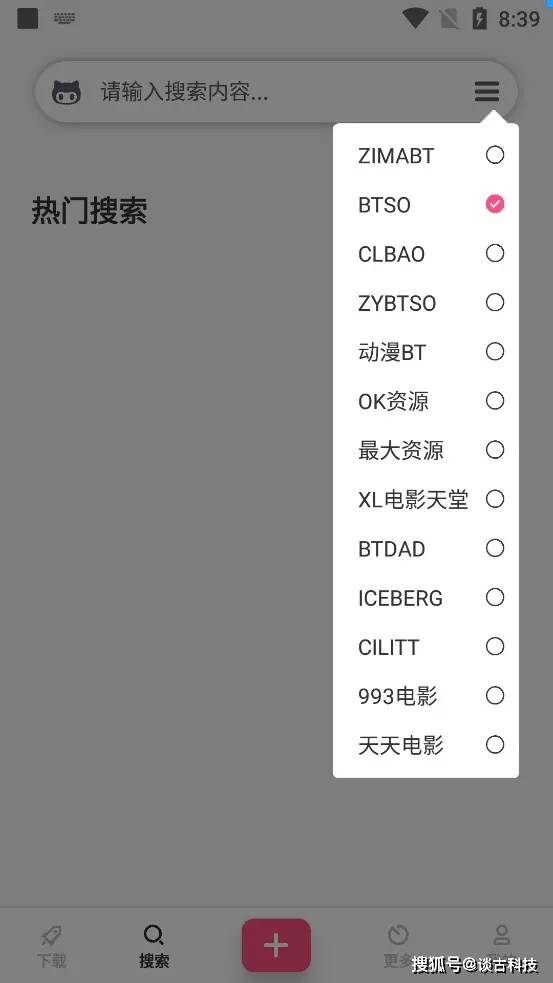

群晖小白系列 篇二十六:从BT到群晖 Download Station 套件的使用网址选项,则可以输入下载链接进行下载。在输入框下方看到支持的链接格式,前面介绍的磁力链接就可以直接粘贴到下面进行下载点击左下角的设置按钮,则可以对 Download Station 的设置进行修改比如启动eMule下载,设置通知等等重点来介绍下BT搜索,Download Station默认自带两个...

法国版OpenAI杀疯了!1760亿参数榜首,杨立昆转发“逆天”评论大模型Mixtral 8x22B磁力链接,模型参数规模高达1760亿,仅次于马斯克的Grok-1,成为市面上参数规模第二大的开源模型。▲Mistral AI发布Mixt... AI搜索平台Perplexity Labs和开源平台Together AI都迅速提供了该模型的支持。AI科学家贾扬清称,通过合理的量化,Mixtral 8x22B可在4个A100...

自动加速器部分文章、数据、图片来自互联网,一切版权均归源网站或源作者所有。

如果侵犯了你的权益请来信告知删除。邮箱:xxxxxxx@qq.com

上一篇:能用的磁力链接搜索网站

下一篇:能用的磁力链接搜索引擎