注意力机制的原理_注意力机制的原理

*** 次数:1999998 已用完,请联系开发者***

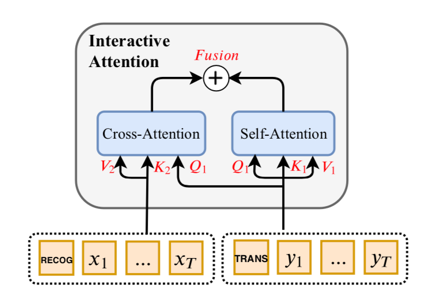

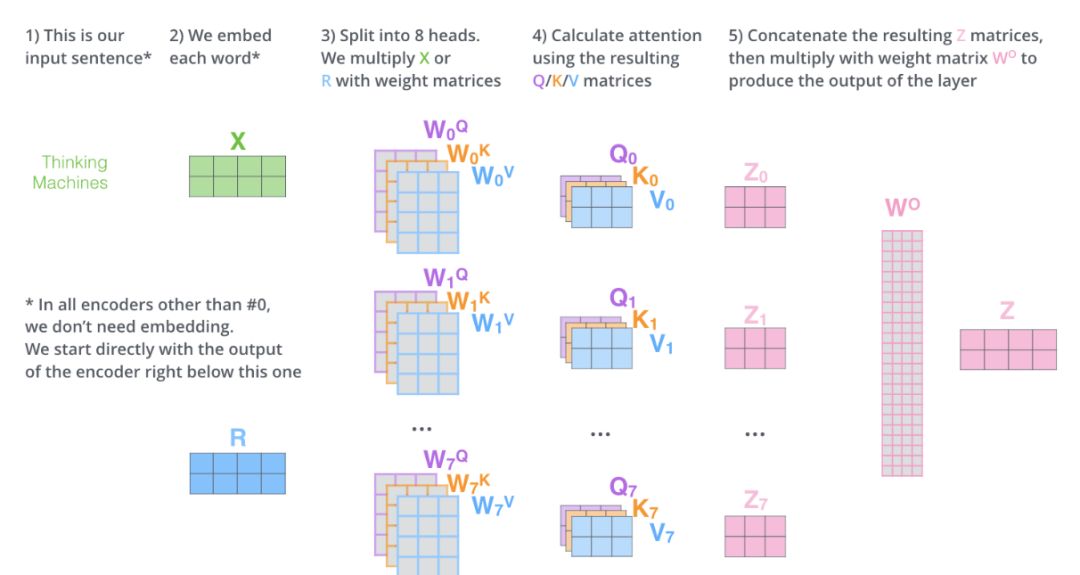

AI绘画中,Transformer的“自注意力机制”有什么作用?自注意力机制就是让模型在处理每个单词时,都能关注到句子中的其他单词,并赋予它们不同的权重。这样一来,模型就能更好地捕捉文本中的语义关系和依赖关系。 让我们以一个简单的例子来解释自注意力机制的原理。假设我们有一个句子:“猫喜欢玩耍,它总是在院子里追逐蝴蝶。”...

∪﹏∪

算法人生(20):从“自注意力机制”看“个人精力怎么管”集中处理:自注意力机制通过集中注意力于少数关键元素,提高了信息处理的效率。个人精力管理也可以遵循类似的原理,尽量减少多任务并行处理,集中精力逐一攻克手头的任务。(虽然多任务并行看上去很高效,但因其会让我们的心思更加散乱,而不是如正念或心流那样,让我们只聚焦于当...

OpenAI在中国申请GPT-6、GPT-7商标ChatGPT 4.0 基于自注意力机制的 Transformer 架构。这是一种基于深度学习的模型,通过大量的数据训练,它能够抓取文本中的复杂模式,并生成新的、连贯的文本。其运行原理是根据前文预测下一个词,以此迭代生成整段文本。ChatGPT 4.0 的优点是参数众多,能够处理多种类型的文本任...

OpenAI在中国申请GPT6、GPT7商标 AI产业发展迅速ChatGPT 4.0基于自注意力机制的Transformer架构。这是一种基于深度学习的模型,通过大量的数据训练,它能够抓取文本中的复杂模式,并生成新的、连贯的文本。其运行原理是根据前文预测下一个词,以此迭代生成整段文本。ChatGPT 4.0的优点是参数众多,能够处理多种类型的文本任务...

自动加速器部分文章、数据、图片来自互联网,一切版权均归源网站或源作者所有。

如果侵犯了你的权益请来信告知删除。邮箱:xxxxxxx@qq.com

上一篇:注意力机制的原理

下一篇:注意力机制的原理及实现